Intelligenza artificiale, linguistica e neuroscienza insieme per il progresso scientifico

Discorsi sintetici generati dai ricordi del cervello

I ricercatori dell’UCSF: un primo passo per realizzare una protesi del linguaggio neurale

[1 Aprile 2020]

Quello che illustra lo studio “Machine translation of cortical activity to text with an encoder–decoder framework”, pubblicato su Nature Neuroscience da Joseph Makin, David Moses, Gopala Anumanchipalli, Josh Chartier ed Edward Chang del Center for integrative neuroscience e del Department of neurological surgery dell’università della California – San Francisco (UCFS), è qualcosa che pensavamo confinato ai film di fantascienza: un’interfaccia cervello-macchina all’avanguardia creata dai neuroscienziati che può generare discorsi sintetici che suonano naturali utilizzando l’attività cerebrale per controllare un tratto vocale virtuale: una simulazione al computer anatomicamente dettagliata che comprende labbra, mascella, lingua e laringe.

I ricercatori spiegano che «Lo studio è stato condotto su dei partecipanti alla ricerca con linguaggio intatto, ma la tecnologia potrebbe un giorno ridare la voca a delle persone che hanno perso la capacità di parlare a causa di paralisi e altre forme di danno neurologico. Ictus, trauma cranico e malattie neurodegenerative come il morbo di Parkinson, la sclerosi multipla e la sclerosi laterale amiotrofica (SLA o morbo di Lou Gehrig) spesso provocano una perdita irreversibile della capacità di parlare. Alcune persone con gravi disabilità del linguaggio imparano a sillabare i loro pensieri lettera per lettera usando dispositivi di supporto che tracciano movimenti oculari o muscolari del viso molto piccoli. Tuttavia, produrre testi o discorsi sintetizzati con tali dispositivi è laborioso, soggetto a errori e dolorosamente lento, in genere consente un massimo di 10 parole al minuto, rispetto alle 100-150 parole al minuto del discorso naturale».

Il nuovo sistema in fase di sviluppo nel laboratorio di Edward Chang dimostra che «E’ possibile creare una versione sintetizzata della voce di una persona che può essere controllata dall’attività dei centri del linguaggio del cervello. In futuro, questo approccio potrebbe non solo ripristinare una comunicazione fluida in soggetti con grave disabilità del linguaggio, ma potrebbe anche riprodurre parte della musicalità della voce umana che trasmette le emozioni e la personalità di chi parla».

Chang aggiunge che «Per la prima volta, questo studio dimostra che possiamo generare intere frasi vocali basate sull’attività cerebrale di un individuo. Questa è una prova entusiasmante del principio secondo cui con la tecnologia che è già a portata di mano, dovremmo essere in grado di costruire un dispositivo clinicamente utilizzabile per i pazienti con perdita del linguaggio».

La ricerca è stata condotta nel laboratorio di Chang dal logopedista Gopala Anumanchipalli e dal bioingegnere Josh Chartier e si basa sullo studio “Encoding of Articulatory Kinematic Trajectories in Human Speech Sensorimotor Cortex”, pubblicato nel 2018 su Neuron dallo stesso team di ricercatori e che descriveva per la prima volta in che modo i centri del linguaggio del cervello umano coordinano i movimenti delle labbra, della mascella, della lingua e di altre componenti del tratto vocale per produrre un linguaggio fluente. Grazie a quello studio, Anumanchipalli e Chartier hanno capito che «I precedenti tentativi di decodificare direttamente il discorso dall’attività cerebrale avrebbero avuto un successo limitato perché queste regioni del cervello non rappresentavano direttamente le proprietà acustiche dei suoni del linguaggio, ma piuttosto le istruzioni necessarie per coordinare i movimenti di bocca e gola durante il discorso».

Anumanchipalli spiega ancora: «La relazione tra i movimenti del tratto vocale e i suoni del parlato che vengono prodotti è complicata. Abbiamo pensato che se questi centri del linguaggio nel cervello codificassero i movimenti piuttosto che i suoni, dovevamo cercare di fare lo stesso nel decodificare quei segnali».

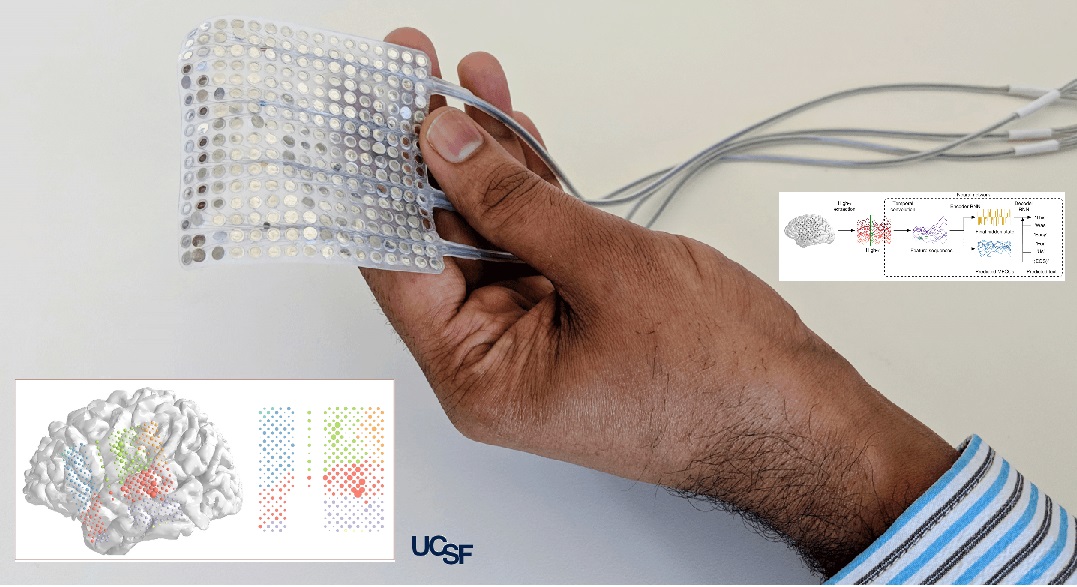

Nel loro nuovo studio, Anumancipali e Chartier hanno chiesto a 5 volontari in cura all’UCSF Epilepsy Center, pazienti con linguaggio intatto a cui erano stati impiantati temporaneamente elettrodi nel cervello per mappare la fonte delle loro convulsioni in preparazione di un intervento di neurochirurgia, di leggere diverse centinaia di frasi mentre i ricercatori registravano l’attività in una regione del cervello nota per essere coinvolta nella produzione linguistica. All’UCSF Sulla base delle registrazioni audio delle voci dei partecipanti, i ricercatori hanno utilizzato i principi linguistici per decodificare i movimenti del tratto vocale necessari per produrre quei suoni: premendo le labbra insieme qui, stringendo le corde vocali lì, spostando la punta della lingua sul palato, poi rilassandola, e così via. Questa mappatura dettagliata del suono nell’anatomia ha permesso agli scienziati di creare un tratto vocale virtuale realistico per ogni partecipante che potrebbe essere controllato dalla loro attività cerebrale. Questo omprendeva due algoritmi di apprendimento automatico della “rete neurale”: un decodificatore che trasforma i modelli di attività cerebrale prodotti durante il parlato in movimenti del tratto vocale virtuale e un sintetizzatore che converte questi movimenti del tratto vocale in un’approssimazione sintetica della voce del partecipante». I ricercatori hanno così scoperto che «Il discorso sintetico prodotto da questi algoritmi era significativamente migliore del discorso sintetico decodificato direttamente dall’attività cerebrale dei partecipanti senza l’inclusione di simulazioni delle vie vocali dei relatori. Gli algoritmi hanno prodotto frasi comprensibili per centinaia di ascoltatori umani nei test di trascrizione crowdsourcing condotti sulla piattaforma Amazon Mechanical Turk».

Come nel caso del linguaggio naturale, i trascrittori hanno avuto più successo quando hanno ricevuto elenchi più brevi di parole tra cui scegliere, come nel caso del personale di cura pronto a raccogliere il tipo di frasi o richieste che i pazienti potrebbero pronunciare. All’UCSF dicono che «I trascrittori hanno identificato accuratamente il 69% delle parole sintetizzate da elenchi di 25 alternative e hanno trascritto il 43% delle frasi con una precisione perfetta. Con più di 50 parole tra cui scegliere, l’accuratezza complessiva dei trascrittori è scesa al 47%, sebbene fossero ancora in grado di comprendere perfettamente il 21% delle frasi sintetizzate».

Chartier riconosce che la strada da fare è ancora lunga ma evidenzia che «Abbiamo ancora altri modi per imitare perfettamente la lingua parlata. Siamo abbastanza bravi a sintetizzare suoni vocali più lenti come “sh” e “z”, nonché a mantenere i ritmi e le intonazioni del discorso, il genere e l’identità di chi parla, ma alcuni dei suoni più bruschi come “b” e “p” sono un po’ sfocati. Tuttavia, i livelli di precisione che abbiamo prodotto qui sarebbero un incredibile miglioramento della comunicazione in tempo reale rispetto a quel che è attualmente disponibile».

I ricercatori stanno attualmente sperimentando una gamma di elettrodi ad alta densità e algoritmi di machine learning più avanzati che sperano possano migliorare ulteriormente il discorso sintetizzato. Il prossimo test importante per la tecnologia è quello di determinare se qualcuno che non può parlare potrebbe imparare ad usare il sistema senza essere in grado di addestrarlo con la sua voce ed estenderlo a tutto ciò che desidera dire. I ricercatori sono fiduciosi: i risultati preliminari di uno dei partecipanti alla ricerca suggeriscono che il sistema anatomico che hanno realizzato «può decodificare e sintetizzare nuove frasi dall’attività cerebrale dei partecipanti quasi come le frasi su cui è stato addestrato l’algoritmo». Anche quando i ricercatori hanno fornito all’algoritmo i dati sull’attività cerebrale registrati mentre un partecipante si limitava a pronunciare frasi senza suono, il sistema era ancora in grado di produrre versioni sintetiche intelligibili delle frasi mimate vocalmente.

I ricercatori hanno anche scoperto che «Il codice neurale per i movimenti vocali si sovrapponeva parzialmente tra i partecipanti e che la simulazione del tratto vocale di un soggetto coinvolto nella ricerca poteva essere adattato per rispondere alle istruzioni neurali registrate dal cervello di un altro partecipante. Insieme, questi risultati suggeriscono che le persone con perdita del linguaggio a causa di insufficienza neurologica potrebbero essere in grado di imparare a controllare una protesi del linguaggio modellata sulla voce di qualcuno con un linguaggio intatto».

Chartier ricorda che «Le persone che non riescono a muovere le braccia e le gambe hanno imparato a controllare gli arti robotici con il cervello. Siamo fiduciosi che un giorno le persone con disabilità del linguaggio saranno in grado di imparare a parlare di nuovo usando questo tratto vocale artificiale controllato dal cervello».

Anumanchipalli conclude: «Sono orgoglioso di essere stati in grado di riunire le competenze di neuroscienze, linguistica e machine learning come parte di questa importante pietra miliare per aiutare i pazienti con disabilità neurologiche».