La terrificante impronta di carbonio dell’intelligenza artificiale

Addestrare un singolo modello di intelligenza artificiale può emettere tanto carbonio quanto 5 auto nel corso della loro vita

[10 Gennaio 2024]

Come fa notare la MIT Technology Rewiew, «L’industria dell’intelligenza artificiale viene spesso paragonata all’industria petrolifera: una volta estratti e raffinati, i dati, come il petrolio, possono essere un bene altamente redditizio. Ora sembra che la metafora possa estendersi ancora oltre. Come la sua controparte basata sui combustibili fossili, il processo di deep learning ha un impatto ambientale enorme».

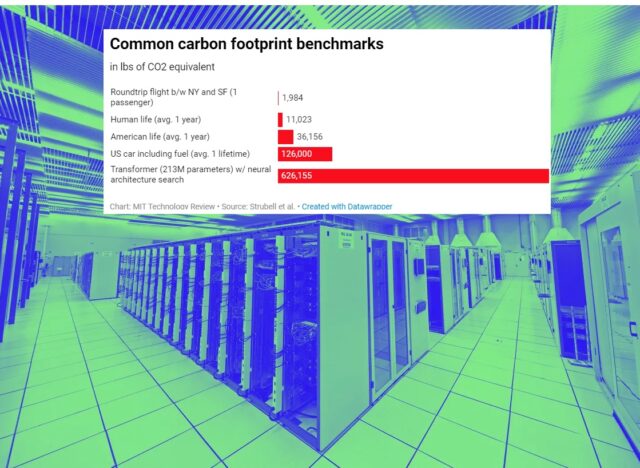

Il MIT si riferisce ai risultati dello studio “Energy and Policy Considerations for Deep Learning in NLP”, pubblicato su arXiv da Emma Strubell, Ananya Ganesh e Andrew McCallum dell’università del Massachusetts – Amherst, che ha realizzato una valutazione del ciclo di vita per l’addestramento di diversi modelli comuni di intelligenza artificiale di grandi dimensioni, scoprendo che «Il processo può emettere più di 626.000 libbre di anidride carbonica equivalente, quasi 5 volte le emissioni dell’intera vita di un’auto americana media (e questo include la produzione dell’auto stessa)».

E’ la sconcertante quantificazione di qualcosa che i ricercatori dell’intelligenza artificiale sospettavano da molto tempo.

Lo studio esamina in particolare il processo di addestramento del modello natural-language processing (NLP), il sottocampo dell’intelligenza artificiale che si concentra su come insegnare a un dispositivo a gestire il linguaggio umano. Negli ultimi due anni, la comunità della PNL ha raggiunto prestazioni notevoli nella traduzione automatica, nel completamento delle frasi e in altre attività di benchmarking standard. Per esempio, il famoso modello GPT-2 di OpenAI scrivere fake news molto convincenti. Ma questi progressi hanno richiesto la formazione di modelli sempre più ampi su vasti insiemi di dati di frasi recuperate da Internet e questo approccio è computazionalmente costoso e ad elevato consumo energetico.

I ricercatori hanno esaminato 4 modelli che sono stati responsabili dei maggiori balzi in avanti termini di prestazioni – Transformer, ELMo, BERT e GPT-2 – e ciascuno si è allenato su una singola GPU, massimo per un giorno, per misurarne il consumo energetico. Il team di ricerca ha poi utilizzato il numero di ore di formazione elencate nei documenti originali del modello per calcolare l’energia totale consumata durante l’intero processo di formazione. Una cifra che è stata convertita in libbre di anidride carbonica equivalente in base al mix energetico medio negli Usa, che corrisponde strettamente al mix energetico utilizzato da AWS di Amazon, il più grande fornitore di servizi cloud.

E’ così che lo studio ha scoperto che «I costi computazionali e ambientali della formazione crescevano proporzionalmente alle dimensioni del modello e poi esplodevano quando venivano utilizzate ulteriori fasi di messa a punto per aumentare la precisione finale del modello».

In particolare, Il processo di ottimizzazione noto come ricerca dell’architettura neurale, che cerca di ottimizzare un modello modificando in modo incrementale la progettazione di una rete neurale attraverso tentativi ed errori esaustivi, «Aveva costi associati straordinariamente elevati con scarsi vantaggi in termini di prestazioni. Senza di esso, il modello più costoso, il BERT, aveva una carbon footprint di circa 1.400 libbre di anidride carbonica equivalente, vicino a un volo transamericano di andata e ritorno per una persona».

Inoltre, i ricercatori sottolineano che queste cifre dovrebbero essere considerate solo come valori di riferimento. La Strubell evidenzia che «La formazione di un singolo modello è la quantità minima di lavoro che puoi fare. In pratica, è molto più probabile che i ricercatori dell’intelligenza artificiale sviluppino un nuovo modello da zero o adattino un modello esistente a un nuovo dataset, entrambi i quali possono richiedere molti più cicli di formazione e messa a punto».

Per comprendere meglio come potrebbe apparire l’intero processo di sviluppo in termini di impronta di carbonio, la Strubell e i suoi colleghi hanno utilizzato come caso di studio un modello che avevano realizzato nel precedente studio “Linguistically-Informed Self-Attention for Semantic Role Labeling”, pubblicato su arXiv nel 2018, e hanno scoperto che «Il processo di costruzione e test di un modello finale cartaceo richiedeva la formazione di 4.789 modelli in un periodo di 6 mesi. Convertito in CO2 equivalente, ha emesso più di 78.000 libbre ed è probabilmente rappresentativo del tipico lavoro svolto sul campo».

Se si considerano gli attuali trend nella ricerca sull’intelligenza artificiale, le ricadute dei risultati del team dell’università del Massachusetts – Amherst sono enormi, come dice su MIT Technology Rewiew Carlos Gómez-Rodríguez, un informatico dell’Universidad de La Coruña che non ha partecipato allo studio, «In generale, gran parte della ricerca più recente sull’intelligenza artificiale trascura l’efficienza, poiché si è scoperto che reti neurali molto grandi sono utili per una varietà di compiti e le imprese e le istituzioni che hanno abbondante accesso alle risorse computazionali possono sfruttarle per ottenere un vantaggio competitivo. Questo tipo di analisi era necessario per aumentare la consapevolezza sulle risorse spese […] e susciterà un dibattito».

Lo studio rende evidente la portata di un fenomeno sottovalutato e i sui risultati sottolineano anche un altro problema crescente nel campo dell’intelligenza artificiale: «L’enorme intensità di risorse ora necessarie per produrre risultati degni di nota ha reso sempre più difficile per le persone che lavorano nel mondo accademico continuare a contribuire alla ricerca».